支持所有RTX显卡!NVIDIA TensorRT带来性能翻倍提升

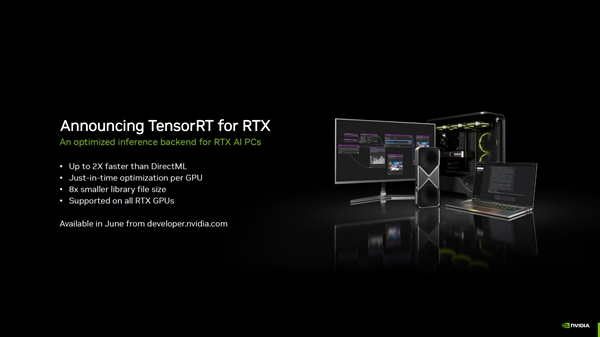

资讯科技5月20日消息,NVIDIA宣布,TensorRT AI推理加速框架现已登陆GeForce RTX显卡,性能比DirectML直接翻倍。

TensorRT是NVIDIA推出的一种推理优化器,能够显著提升AI模型的运行效率,此次,NVIDIA将TensorRT引入RTX平台,使得所有RTX显卡的用户都能享受到更快的AI性能。

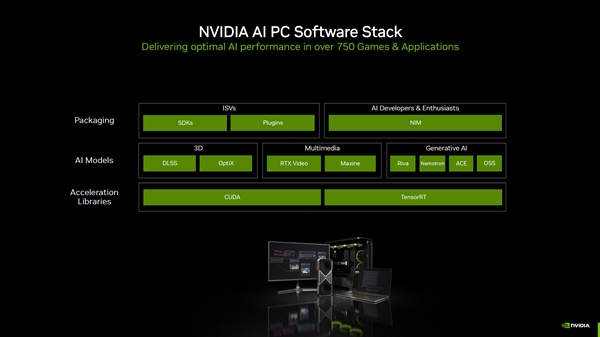

根据NVIDIA的介绍,TensorRT不仅支持原生Windows ML,还能够自动选择合适的硬件来运行每个AI功能,并下载相应的执行提供程序,极大地简化了开发流程。

在性能方面,NVIDIA展示了TensorRT与DirectML的对比数据:在ComfyUI中,使用TensorRT的用户可以获得高达2倍的性能提升;在DaVinci Resolve和Vegas Pro中,性能提升达到了60%。

此外,TensorRT for RTX还带来了其他优势,例如8倍更小的库文件大小和针对每个GPU的即时优化,这些改进不仅提升了性能,还优化了软件的存储和管理。

TensorRT for RTX将在6月正式推出,NVIDIA还在不断扩展其AI SDKs,目前正为超过150个AI SDK提供支持,本月将推出5个新的ISV集成,包括LM Studio、Topaz Video AI、Bilibili、AutoDesk VRED和Chaos Enscape等。