上海AI实验室造出首个「通才」机器人大脑:看懂世界+空间推理+精准操控全拿下

机器人的新大脑框架来了!

上海人工智能实验室联合多家单位提出了一种全新的通用具身智能大脑框架:Visual Embodied Brain,简称VeBrain。

该模型通过同时集成视觉感知、空间推理和机器人控制能力,可实现多模态大模型(MLLM)对物理实体的直接操控,使机器人能像人类一样 " 看到 - 思考 - 行动 "。

相比现有的 MLLM 和视觉 - 语言 - 动作 ( VLA ) 模型,VeBrain 具备以下亮点:

统一三类任务的语言建模范式

将机器人控制转化为 MLLM 中常规的 2D 空间文本任务,通过关键点检测与具身技能识别等任务,打通感知、推理、控制三大能力的建模路径;

提出 " 机器人适配器 " 实现闭环控制

由关键点追踪、动作控制、技能执行和动态接管模块组成,实现从文本决策到真实动作的精准映射;

构建高质量多能力数据集 VeBrain-600k

涵盖 60 万条指令数据,覆盖多模态理解、视觉 - 空间推理、机器人操作三类任务,辅以多模态链式思维(Multimodal CoT)标注,提升模型组合推理能力;

卓越的多模态和真机性能

同时实现匹配同参数量下最强开源模型 QwenVL-2.5 的多模态能力,同参数量下最优的空间推理能力,以及分别在机械臂和机器狗两个实体上验证的真机控制能力。

测试结果表明,VeBrain 在视觉感知、空间推理和机器人控制能力上同时取得了最先进的性能。

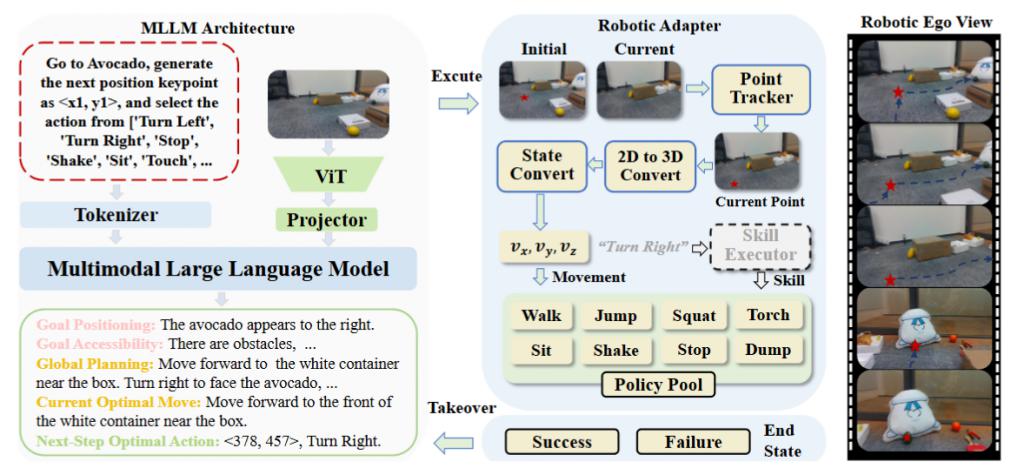

VeBrain 架构:统一感知 - 推理 - 控制建模范式

当前 MLLM 在多模态感知方面表现卓越,但难以直接迁移到机器人控制等物理任务中,主要瓶颈在于任务目标空间的不一致。

而 VeBrain 打破这一限制,提出将机器人控制重构为两个通用 MLLM 子任务:

关键点检测(Keypoint Detection)

以图像为输入,预测二维目标位置,作为运动锚点;

技能识别(Skill Recognition)

基于上下文生成语义动作,如 " 前进 "、" 夹取 "、" 转身 " 等。

通过此类语言化的建模方式,VeBrain 控制任务得以与理解和推理任务共享统一的输入输出空间,能够有效对抗多任务冲突与灾难性遗忘。

VeBrain 的另一个核心创新是机器人适配器模块,其组成包括:

点追踪器 ( Point Tracker )

实时更新四足机器人在运动过程中的视角下关键点;

运动控制器 ( Movement Controller )

结合 RGBD 相机获取深度信息,将 2D 坐标转换为 3D 控制指令;

策略执行器 ( Skill Executor )

调用预训练的低层控制策略(如行走、夹取)完成任务执行;

动态接管 ( Dynamic Takeover )

在出现目标丢失或策略失败时,自动回调语言模型进行重规划。

该模块实现了 MLLM 与机器人之间的闭环通信,提升了机器人在动态环境中的稳定性与鲁棒性。

VeBrain-600k:统一训练多能力模型的高质量数据集

为支撑模型的统一训练,VeBrain 团队还配套了 VeBrain-600k 数据集,包含:

20 万条多模态理解数据:整合图像、视频与文本,来源于 ShareGPT4V、MMInstruct 等;

31.2 万条空间推理数据:结合 ScanNet 点云数据,生成涉及计数、距离、尺寸等空间理解任务;

8.8 万条机器人控制数据:由人工采集、标注的真实机器人操作数据,覆盖四足机器人与机械臂两类平台;

此外,大量任务引入链式思维(Chain-of-Thought,CoT)结构,由 GPT-4o 与 Gemini 自动生成推理过程并经专家复核,极大提升了数据质量与任务复杂度。

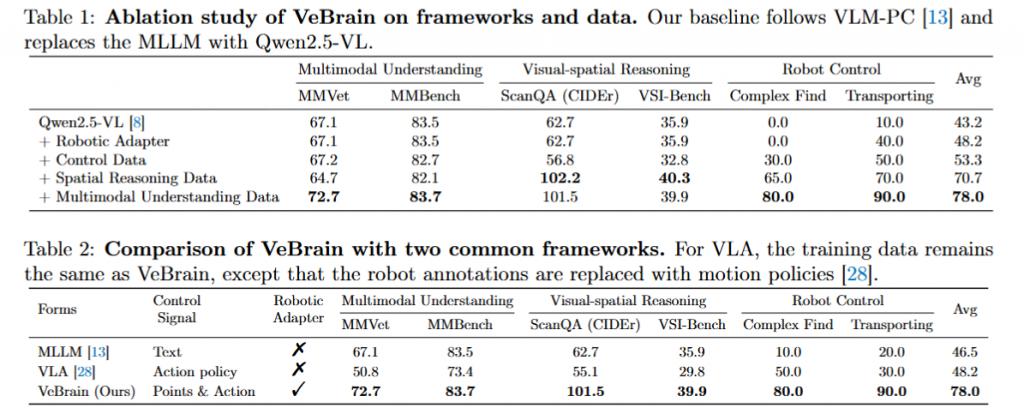

通过消融实验,VeBrain 团队验证了 VeBrain-600k 数据集的丰富性和必要性。

从表格中可以看到,尽管在多模态理解方面表现良好,现有的 MLLM 在视觉空间推理和机器人控制方面往往表现不足," 复杂寻找 " 任务的成功率仅为 0%。而在为模型配备我们的机器人适配器后,Qwen2.5-VL 在两个机器人控制任务上的成功率明显提高。

将 VeBrain 与两个常用框架,即 MLLM 和 VLA 进行比较,发现 MLLM 由于控制能力较弱,在两项任务中难以直接控制机器人;而 VLA 虽然在机器人控制任务中表现良好,但大大牺牲了多模态能力。与这些框架相比,VeBrain 在所有任务中实现了最佳权衡性能,相较于其他框架平均提升了31.5%。

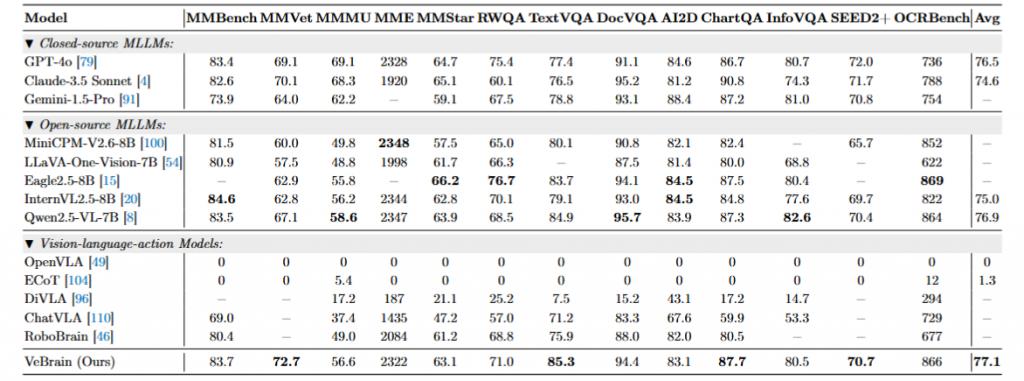

性能测试结果:多模态理解 + 空间智能 + 机器人控制三位一体

VeBrain 团队在 13 个多模态 benchmark 和 5 个空间推理 benchmark 上测试了 VeBrain 的性能。结果表明,VeBrain 实现了比肩当前最强开源模型 Qwen2.5-VL 的多模态能力,以及同参数量下最优的视觉空间推理能力。

可以看到,VeBrain 在 MMVet(+5.6%)、DocVQA(94.4 分)等 13 个基准上超越 GPT-4o 和 Qwen2.5-VL,并取得了 77.1 的最佳归一化平均性能,这表明其具有更强的多模态能力。

模型需要强大的 3D 空间感知和推理能力来回答不同类型的问题,大多数先前方法采用了基于 3D 的 MLLM 结构,并在四个基准测试上取得了有希望的结果。

相比之下,直接将 2DMLLM 迁移到这些任务会导致性能差,例如 Qwen2.5-VL-7B 的 -50.1Acc@0.25,这表明它们在 3D 空间理解和推理方面的不足。与这些方法相比,GPT4Scene-HDM 通过基于视频的 2DMLLM 和对象标记取得了更好的结果,但作为一个专业模型,GPT4Scene-HDM 难以应用于常见的 2D 多模态任务。

而 VeBrain 作为一个通才 MLLM,在 3D 场景问答(ScanQA CIDEr 101.5)和物体定位(ScanRefer Acc@0.25 66.4%)上刷新了纪录,甚至在所有任务上都能超越 GPT4Scene-HDM。

进一步诊断现有 MLLM 和 VeBrain 的视觉空间推理能力。可以看出,VeBrain 在 VSI 基准测试中的平均得分优于所有现有的 MLLM,例如,比 Qwen2.5-VL-7B 高出 +4.0%。与 GPT-4o 等更大的 MLLM 相比,VeBrain 也能表现更出色。

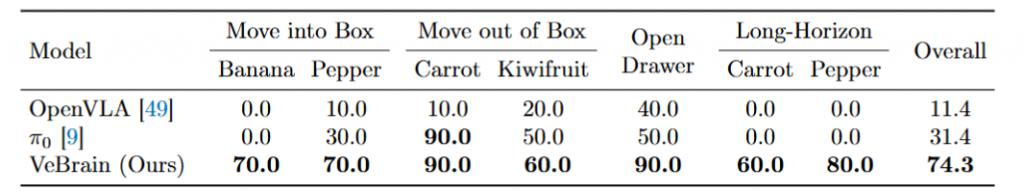

为了证明 VeBrain 的泛化性和通用性,选择四足机器人和机械臂作为真机验证的两个实体。可以看到,在四足机器人尤其是复杂的长程任务上,VeBrain 相比于现有的 VLA 模型和 MLLM 模型取得了 +50% 成功率的提升。

在机械臂尤其是长程任务上,VeBrain 相比于 π 0 模型也取得了显著的提升。

论文链接:https://huggingface.co/papers/2506.00123/

项目主页:https://internvl.github.io/blog/2025-05-26-VeBrain/

推理代码 & 模型链接:https://internvl.github.io/blog/2025-05-26-VeBrain/

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

— 完 —

点亮星标

科技前沿进展每日见